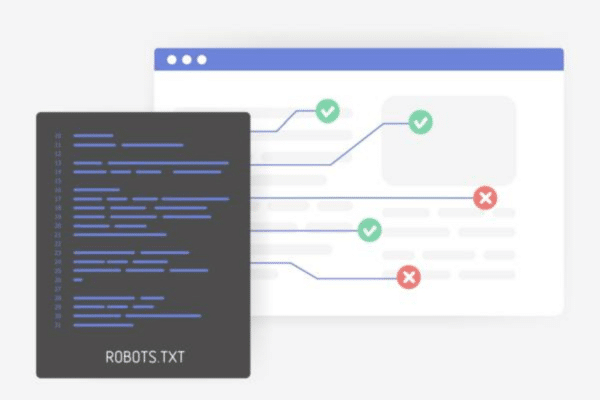

O que é um ficheiro robots.txt?

Já ouviste falar deste termo mas não o entendes? Um ficheiro robots.txt é como um segurança virtual que guarda a entrada do teu site. A sua função é informar os robots dos motores de busca sobre as áreas que podem visitar e as que devem evitar.

Essencialmente, o arquivo robots.txt serve como um conjunto de instruções para os bots dos mecanismos de pesquisa, orientando-os sobre onde podem explorar o seu site e onde não são bem-vindos. Podes saber mais sobre o ficheiro robots.txt na secção Rastreio e indexação da documentação para programadores do Google.

Agora, por que razão te dás ao trabalho de otimizar o teu ficheiro robots.txt? Bem, pensa assim: da mesma forma que não convidarias um touro para uma loja de porcelana delicada para evitar danos, também não queres que os motores de busca rastreiem indiscriminadamente e indexem todas as páginas do teu site.

Ao otimizar o seu robots.txt, comunica eficazmente aos motores de busca quais as partes do seu sítio que devem ser evitadas e quais as áreas a que podem aceder.

O que deve constar em robots.txt?

É aqui que começa a verdadeira diversão. Queres que o teu site seja indexado pelos motores de busca, mas também queres manter certas partes privadas. Então, como é que consegues esse equilíbrio? Vamos lá a explicar-te.

Permite as coisas boas

Começa com a diretiva “Permitir”. Se tens conteúdo que queres que as pessoas vejam, permite que os motores de busca acedam a ele. Por exemplo:

User-agent: Googlebot

Allow: /awesome-content/Não permite o lixo

Por outro lado, existe a diretiva “Disallow”. Utiliza-a para manter os bots dos motores de busca afastados de páginas que não acrescentam valor, como páginas de início de sessão ou painéis de administração. Por exemplo:

User-agent: *

Disallow: /login/Desculpa, bots, não há passes para os bastidores para ti!

Regras para utilizadores-agentes específicos

Podes criar regras específicas para diferentes bots de motores de busca. Por exemplo:

User-agent: Bingbot

Disallow: /not-for-bing/Estás a dizer ao Bingbot: “Não podes entrar aqui”!

Erros comuns a evitar

Lembra-te, o robots.txt pode ser uma faca de dois gumes, por isso usa-a com sabedoria:

- Bloquear todos os bots: A menos que queiras sair da grelha, não bloqueies todos os bots com um wildcard (*), a menos que tenhas uma razão muito boa. Quando bloqueias todos os bots, estás essencialmente a dizer ao mundo que o teu site está fechado para negócios.

- Utilizar regras irrelevantes: Não cries regras para secções do teu Web site que pretendes que os motores de busca indexem.

- Negligenciar as actualizações: O teu Web site evolui, tal como o teu ficheiro robots.txt. Actualiza-o regularmente para acompanhar a evolução do teu site.

Extra: Não te esqueças de testar o teu robots.txt

Faz um teste antes de lançares o teu robots.txt recentemente optimizado no teu Web site ativo. O Google tem uma ferramenta útil para isso – o testador de robots.txt no Google Search Console.

Melhores práticas para robots.txt

Aqui estão alguns conselhos de ouro sobre as melhores práticas para os ficheiros robots.txt:

Adiciona referências ao mapa do site: Inclui referências aos teus sitemaps no teu robots.txt para ajudar os motores de busca a encontrar e a rastrear o teu conteúdo de forma eficiente.

Verifica se existem erros: Verifica regularmente se existem erros no teu robots.txt. Regras quebradas ou demasiado restritivas podem prejudicar seriamente o teu SEO.

Mantém-te informado: Mantém-te atualizado sobre as diretrizes dos motores de busca. O Google e outros motores de busca podem alterar o seu comportamento de rastreio ao longo do tempo.

Um exemplo de robots.txt

Agora, vamos arregaçar as mangas e pôr mãos à obra. Aqui está um exemplo real de um ficheiro Robots.txt para te mostrar como pôr estes conceitos em ação:

User-agent: *

Disallow: /private/

Disallow: /admin/

Disallow: /temp/

User-agent: Googlebot

Allow: /blog/

Allow: /products/

Disallow: /private/

User-agent: Bingbot

Allow: /products/

Disallow: /temp/Neste exemplo, temos três secções, cada uma dirigida a diferentes utilizadores-agentes – o wildcard universal (*), o Googlebot e o Bingbot. Isto demonstra como podes criar regras para bots de motores de busca específicos, mantendo regras gerais para todos os bots.

- Para todos os bots, os diretórios /private/, /admin/, e /temp/ estão fora dos limites.

- O Googlebot tem acesso às secções /blog/ e /products/, que são os espaços públicos do sítio Web.

- O Bingbot tem permissão para rastrear a secção /products/ mas é-lhe negado o acesso ao diretório /temp/.

Lembra-te de que as regras específicas e os caminhos de diretório devem ser adaptados à estrutura e ao conteúdo do teu sítio Web. Este é apenas um exemplo básico para ilustrar o conceito.

Ferramentas para gerar robots.txt automaticamente

Agora, compreendo que criar um ficheiro robots.txt manualmente pode ser uma tarefa assustadora, especialmente se estiveres a lidar com uma estrutura de site complexa. Felizmente, existem várias ferramentas disponíveis para te ajudar a gerar ficheiros robots.txt de forma rápida e precisa. Abaixo, vamos explorar as melhores ferramentas para diferentes plataformas de site:

Robots.txt para WordPress

- Plugin Yoast SEO: Este plugin é obrigatório se estiveres a gerir um site WordPress. Ajuda com o SEO on-page e inclui uma funcionalidade de fácil utilização para gerar e editar o teu ficheiro robots.txt.

- Pacote SEO tudo em um: Outro popular plugin de SEO para WordPress, o All in One SEO Pack, também oferece uma opção para gerar e personalizar o teu ficheiro robots.txt. É uma excelente escolha para aqueles que preferem uma alternativa ao Yoast.

Robots.txt para Shopify

- Aplicações de gestão de SEO da Shopify: a Shopify oferece várias aplicações de gestão de SEO, como o Plug in SEO e o SEO Manager, que incluem funcionalidades de gerador de robots.txt. Estas aplicações foram especificamente concebidas para os utilizadores da Shopify, tornando a configuração do robots.txt mais fácil e mais adaptada aos sítios de comércio eletrónico.

Robots.txt para Webflow

- Ferramentas incorporadas no Webflow: Os utilizadores do Webflow têm a vantagem de utilizar as definições de SEO nativas da plataforma. Pode personalizar facilmente o seu ficheiro robots.txt no Webflow, indo às definições do projeto e navegando até à secção SEO. A funcionalidade está integrada na plataforma, simplificando o processo para designers e programadores.

Robots.txt para Wix

- Wix SEO Wiz: O Wix oferece um SEO Wiz que ajuda os utilizadores a gerar um ficheiro robots.txt. Fornece um guia passo a passo para otimizar a SEO do seu sítio Web, incluindo a criação e configuração do seu ficheiro robots.txt.

- Ferramentas de SEO de terceiros: Embora as funcionalidades de SEO nativas do Wix sejam fáceis de utilizar, podes optar por ferramentas de SEO de terceiros que se destinam a sítios Web Wix. Ferramentas como SiteGuru ou SEMrush podem ajudar-te a criar e gerir eficazmente o teu ficheiro robots.txt.

Estas ferramentas e plugins foram concebidos para facilitar a tua vida. Automatizam a criação de um ficheiro robots.txt e oferecem frequentemente interfaces de fácil utilização para personalizar as regras com base nas suas necessidades específicas.

Na UniK SEO, recebemos constantemente as mesmas perguntas sobre o robots.txt. Como bónus, encontrarás as perguntas mais frequentes abaixo. A nossa equipa de SEO tentará responder-te da forma mais breve possível.

Todos os motores de busca seguem as regras do robots.txt?

A maioria dos principais motores de busca, incluindo o Google, o Bing e o Yahoo, seguem as regras Robots.txt. No entanto, os motores de busca mais pequenos e menos populares podem nem sempre obedecer a estas diretivas.

Posso ocultar informações sensíveis utilizando o robots.txt?

Não, o robots.txt não é uma medida de segurança. É apenas uma orientação para os motores de busca. Se precisares de proteger dados sensíveis, utiliza outros meios, como a proteção por palavra-passe.

O robots.txt é o mesmo que uma etiqueta “noindex”?

Não, não são a mesma coisa. O Robots.txt controla o rastreio, enquanto uma etiqueta “noindex” numa página Web diz aos motores de busca para não indexarem essa página específica.

Ainda estás a tentar descobrir como otimizar o teu robots.txt? Entra em contacto agora para uma análise SEO gratuita!

Luís Inverno is a Senior SEO Strategist & Analyst at UniK SEO with over 15 years of experience in digital marketing. His expertise spans SEO, PPC, e-commerce, and content strategy. At UniK SEO, he leads the development and implementation of data-driven strategies to boost organic traffic and drive lead generation for clients.